De vraag “Is Claude AI veilig?” wordt steeds relevanter nu organisaties en professionals generatieve AI toepassen in uiteenlopende contexten. In deze analyse bekijken we de Claude AI veiligheid op basis van recente beleidswijzigingen, technische maatregelen en concrete praktijkvoorbeelden.

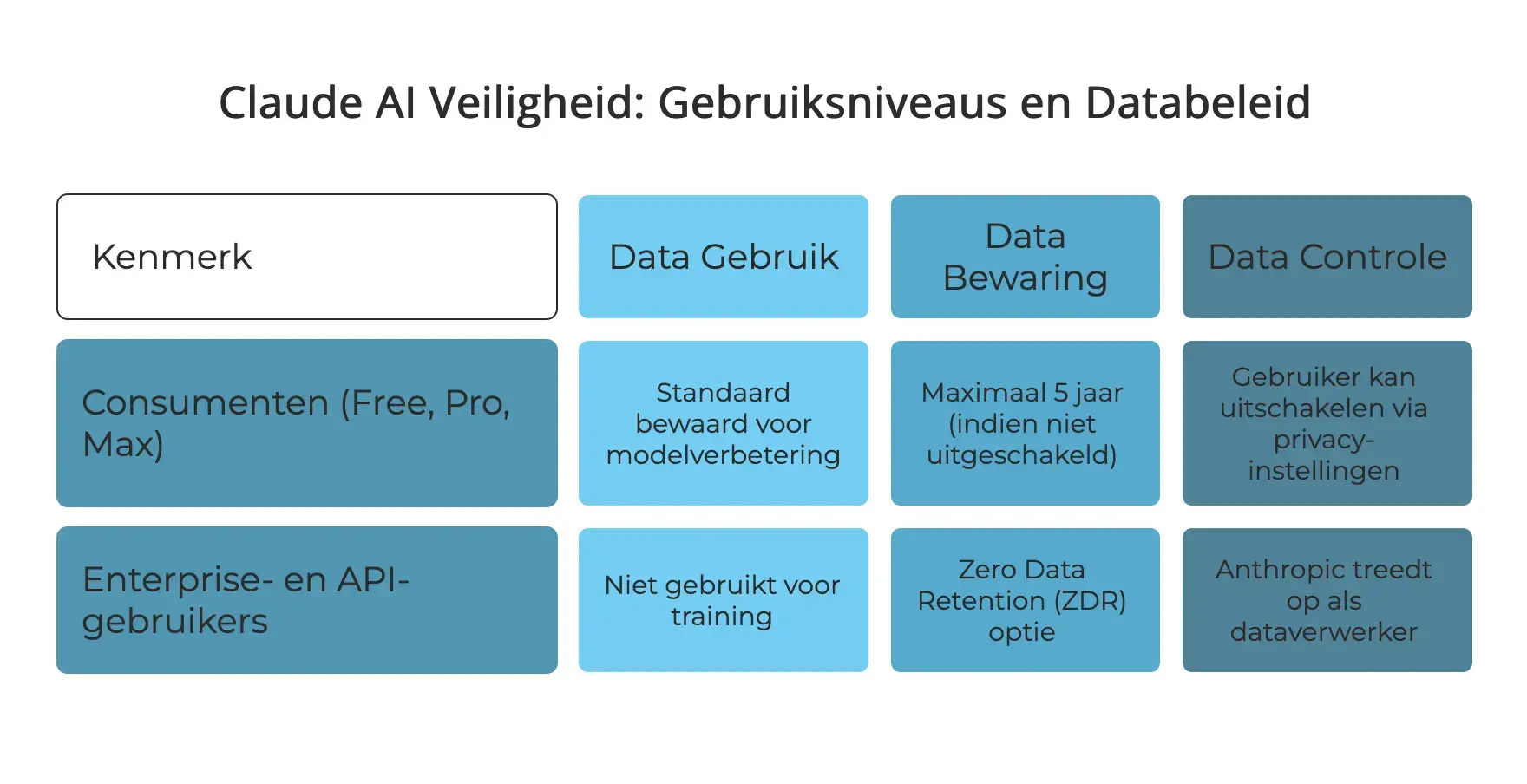

Gebruiksniveaus en databeleid

Claude’s databeleid is afgestemd op het type gebruiker:

- Consumenten (Free, Pro, Max):

- Data wordt standaard bewaard om modellen te verbeteren.

- Je kunt dit eenvoudig uitschakelen via de privacy-instellingen.

- Niet-uitgeschakelde data wordt maximaal 5 jaar bewaard.

- Enterprise- en API-gebruikers:

- Data wordt niet gebruikt voor training.

- Er zijn opties voor Zero Data Retention (ZDR), waarbij gegevens direct worden verwijderd na veiligheidschecks.

- Anthropic treedt hierbij op als dataverwerker, wat organisaties juridische controle biedt.

Deze differentiatie maakt het mogelijk om Claude op maat in te zetten, afhankelijk van je behoeften aan privacy en databeheer.

Constitutional AI: Claude’s benadering van veiligheid

Anthropic hanteert een unieke trainingsaanpak genaamd Constitutional AI. Hierbij leert Claude zichzelf corrigeren aan de hand van vastgelegde principes, zoals:

- Respect voor privacy

- Transparantie

- Verantwoorde outputkeuzes

Dit gebeurt via AI-feedback in plaats van menselijke beoordeling, en zorgt ervoor dat Claude bewust keuzes maakt die in lijn zijn met ethische richtlijnen. Het resultaat is een AI-model dat doorgaans consistente uitleg geeft over waarom bepaalde verzoeken wel of niet worden beantwoord.

Beveiligingsmaatregelen en certificeringen

Claude voldoet aan diverse internationale standaarden:

- SOC 2 Type I & II

- ISO 27001:2022 en ISO 42001:2023

- CSA STAR Level 2

- HIPAA-configuratie voor zorgtoepassingen

Technische maatregelen omvatten onder andere:

- Encryptie in transit (TLS) en bij opslag (AES-256)

- Rolgebaseerde toegangscontrole en multi-factor authenticatie

- Beveiligde omgevingen voor Claude Code met sandboxing en commandotoestemming

Deze opzet biedt een solide basis voor toepassingen waarbij gegevensbeveiliging centraal staat.

Aandachtspunten uit de praktijk

In november 2025 werd een casus bekend waarbij een geavanceerde actiegroep Claude gebruikte als onderdeel van een bredere cybercampagne. Het incident betrof een klein aantal doelwitten en leidde tot aanvullende interne veiligheidsmaatregelen bij Anthropic.

Hoewel dergelijke situaties uitzonderlijk zijn, tonen ze aan dat proactieve instellingen en bewust gebruik belangrijk blijven — ongeacht welk AI-platform wordt ingezet.

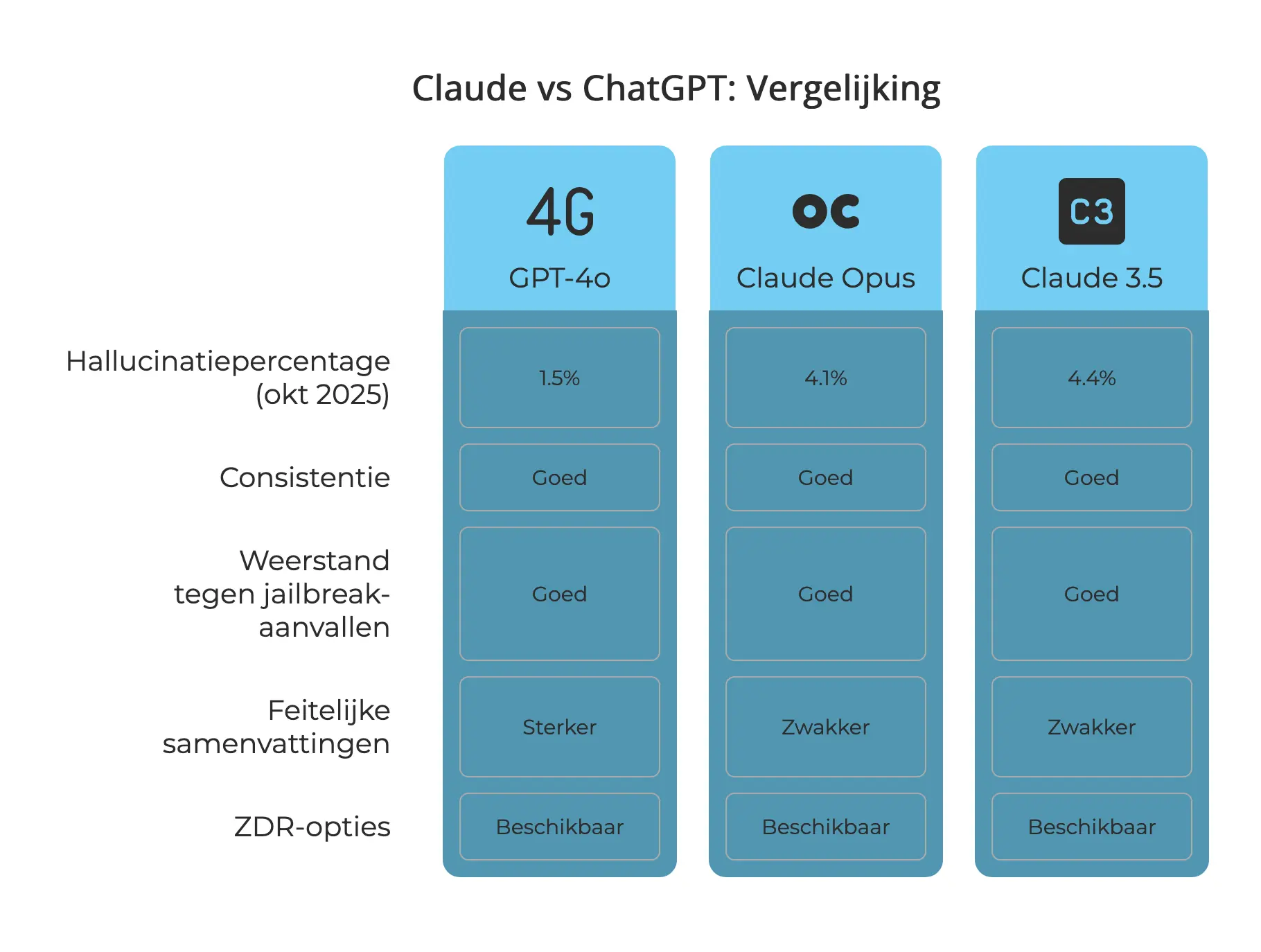

Claude vs ChatGPT: een vergelijkende blik

ModelHallucinatiepercentage (okt 2025)GPT-4o1.5%Claude Opus 4.14.2%Claude 3.54.4%

In benchmarktests scoort Claude goed op consistentie en weerstand tegen jailbreak-aanvallen. GPT-4 presteert sterker in feitelijke samenvattingen. Beide modellen bieden ZDR-opties voor enterprisegebruik.

Eigendom van Claude-uitvoer

Anthropic erkent gebruikersrechten op input en draagt eventuele rechten op outputs over aan de gebruiker, voor zover de wet dat toestaat. Voor organisaties die met Claude Code werken, zijn er aanvullende juridische zekerheden beschikbaar via enterprise-contracten.

Praktische aanbevelingen

Voor wie Claude gebruikt in een professionele of gevoelige context:

- Controleer of je data gedeeld wordt en pas dit aan waar nodig

- Gebruik incognitomodus voor vertrouwelijke gesprekken

- Vermijd het invoeren van persoonlijke of bedrijfskritische informatie op consumentenaccounts

- Voor structureel gebruik: overweeg Claude voor Teams of API-oplossingen met ZDR

Conclusie

Claude AI veiligheid is gebaseerd op sterke technische en ethische fundamenten, met een duidelijke differentiatie tussen gebruikersniveaus. Voor wie bewust omgaat met instellingen en gebruiksvorm, biedt Claude een betrouwbare AI-partner.

Veilige AI begint met heldere keuzes. Door instellingen correct in te richten en het juiste gebruiksniveau te kiezen, haal je het maximale uit Claude — op een manier die past bij je privacy- en compliancevereisten.